Comment fonctionnent les détecteurs de contenu IA pour vérifier la présence d'IA

Découvrez comment les détecteurs de contenu IA parviennent à distinguer les textes rédigés par des humains de ceux générés par l'IA, grâce à une explication simple de la technologie de pointe qui se cache derrière ces outils.

En 2026, on estime que 90 % du contenu en ligne pourrait être généré par l'IA. Il n'a jamais été aussi crucial de pouvoir faire la différence entre le contenu généré par des humains et celui généré par l'IA, mais comment fonctionnent réellement les détecteurs de contenu IA ? Nous vous dévoilons ici la science derrière ces systèmes sophistiqués.

Points clés

- Les détecteurs d'IA analysent la manière dont le texte est rédigé, sa formulation, son rythme et sa structure, afin de déterminer s'il a été créé par un humain ou par une IA.

- Ils recherchent des schémas tels que le caractère prévisible de l'écriture (appelé perplexité) et les variations de longueur et de ton (c'est-à-dire le traitement du langage naturel) afin de repérer la différence entre l'expression humaine naturelle et le style plus uniforme de l'IA.

- Ces outils sont utilisés dans les écoles, les entreprises, les médias et le recrutement afin de vérifier que le contenu est authentique et reflète véritablement l'effort et la voix d'un être humain.

- Aucun détecteur n'est infaillible, car ils peuvent commettre des erreurs, en particulier avec des textes courts, modifiés ou mixtes. Le discernement humain fait donc toujours partie du processus.

- À l'avenir, les outils de détection deviendront plus avancés et s'étendront au-delà du texte pour analyser les images et les vidéos, dans le but de préserver la transparence de la créativité et de mettre en avant l'originalité de l'être humain.

Qu'est-ce qu'un détecteur de contenu IA ?

Les détecteurs de contenu IA sont des outils qui analysent un texte afin de déterminer s'il a été rédigé par un humain ou par un système IA. Ils se basent sur des algorithmes pour examiner l'utilisation des mots, la structure des phrases et la signification du texte, en le comparant à de vastes ensembles de données comprenant des contenus connus générés par l'IA et rédigés par des humains.

Si vous vous demandez « comment fonctionnent les détecteurs d'IA », voici une réponse en bref : ils examinent les modèles linguistiques et statistiques afin d'évaluer le degré de prévisibilité ou de variété d'un texte.

Chez GPTZero, notre modèle de détection a été validé par un organisme tiers, le Penn State AI Research Lab (2024). Nos travaux ont également été cités dans The New York Times, Forbes et CNN, un témoignage de leur rôle reconnu dans l'élaboration de normes responsables en matière de détection de l'IA.

Comment fonctionnent les détecteurs d'IA ?

La plupart des détecteurs, y compris GPTZero, utilisent une combinaison de techniques linguistiques, d'apprentissage profond et d'interprétabilité, ce qui signifie que notre modèle ne se contente pas de classer les résultats, mais également d’expliquer pourquoi. Ce principe d'« explicabilité » s'aligne sur les nouvelles directives de transparence de l'OCDE et de l'UNESCO en matière d'IA responsable.

De nombreux détecteurs de contenu IA s'appuient sur les mêmes techniques que celles utilisées par les modèles IA tels que ChatGPT pour créer du langage, notamment l'apprentissage automatique (machine learning - ML) et le traitement du langage naturel (natural language processing - NLP).

Apprentissage automatique (ML)

L'apprentissage automatique consiste à reconnaître des modèles : plus le texte analysé est long, plus les outils peuvent facilement détecter les différences subtiles entre le contenu généré par l'IA et celui généré par l'homme.

Notre pipeline de ML est continuellement mis à jour avec les résultats des derniers modèles d'IA, notamment GPT-4o, Claude 3 et Gemini 1.5, garantissant une détection fiable des systèmes de nouvelle génération. L'apprentissage automatique alimente l'analyse prédictive, essentielle pour mesurer la perplexité (nous y reviendrons plus tard), un indicateur clé de texte généré par l'IA.

Traitement du langage naturel (NLP)

Le traitement du langage naturel porte sur les nuances du langage et aide les détecteurs d'IA à évaluer le contexte et la syntaxe du texte qu'ils analysent. L'IA peut créer des phrases grammaticalement correctes, mais a souvent du mal à faire preuve de créativité, de subtilité et de profondeur de sens (ce que les humains utilisent naturellement dans leurs écrits).

Classifieurs et embeddings

Au sein de ces grandes catégories que sont le ML et le NLP, les classifieurs et les embeddings jouent un rôle important dans le processus de détection.

Les classifieurs classent les textes en groupes en fonction des modèles qu'ils ont appris : cela revient à enseigner à quelqu'un à trier des fruits en fonction des caractéristiques qu'il a apprises, mais appliqué au langage.

Les embeddings représentent les mots ou les phrases sous forme de vecteurs et créent une sorte de carte du langage, ce qui permet ensuite aux détecteurs d'IA d'analyser la cohérence sémantique.

Une alternative potentielle : les filigranes

Une autre approche explorée par les chercheurs consiste à utiliser des filigranes d'IA, qui sont des signaux cachés intégrés dans le texte généré par l'IA pendant le processus de création, et qui lui permettent de l'identifier. Bien que les filigranes restent prometteurs, la plupart des experts (y compris OpenAI et Anthropic) reconnaissent qu'il ne s'agit pas encore d'une solution fiable ou conforme aux normes du secteur en raison des risques de falsification. Le principal obstacle à leur mise en œuvre est que les filigranes peuvent être supprimés, modifiés ou falsifiés assez facilement.

Méthodes utilisées par les détecteurs d'IA

Les détecteurs d'IA s'appuient sur un ensemble d'indices linguistiques et techniques et analysent le caractère naturel ou prévisible du texte, en examinant la structure et la variation des phrases. Les textes générés par l'IA suivent souvent des schémas cohérents et répètent des phrases usuelles, tandis que les textes rédigés par des humains ont tendance à surprendre le lecteur par leur créativité et leur originalité.

Certains systèmes recherchent des « filigranes » numériques cachés, ou traces de métadonnées intégrées lors de la génération du texte, mais ceux-ci peuvent facilement disparaître lorsque le texte est retravaillé ou traduit. D'autres comparent le texte à de vastes bases de données de contenus générés par l'IA afin d'identifier des schémas récurrents, mais cette méthode perd de son efficacité à mesure que les modèles d'IA deviennent plus performants et diversifiés dans leurs capacités linguistiques.

Techniques clés dans la détection de contenu généré par l'IA

GPTZero a été l'un des premiers détecteurs d'IA à exploiter les concepts de « perplexité » et d’« irrégularité » pour évaluer les textes. Depuis lors, nous avons perfectionné notre modèle et l'avons enrichi de plusieurs couches, pour aboutir à un système à sept composantes permettant de déterminer si un texte a été généré par une IA. Il est toutefois utile de revenir sur les origines de ce modèle.

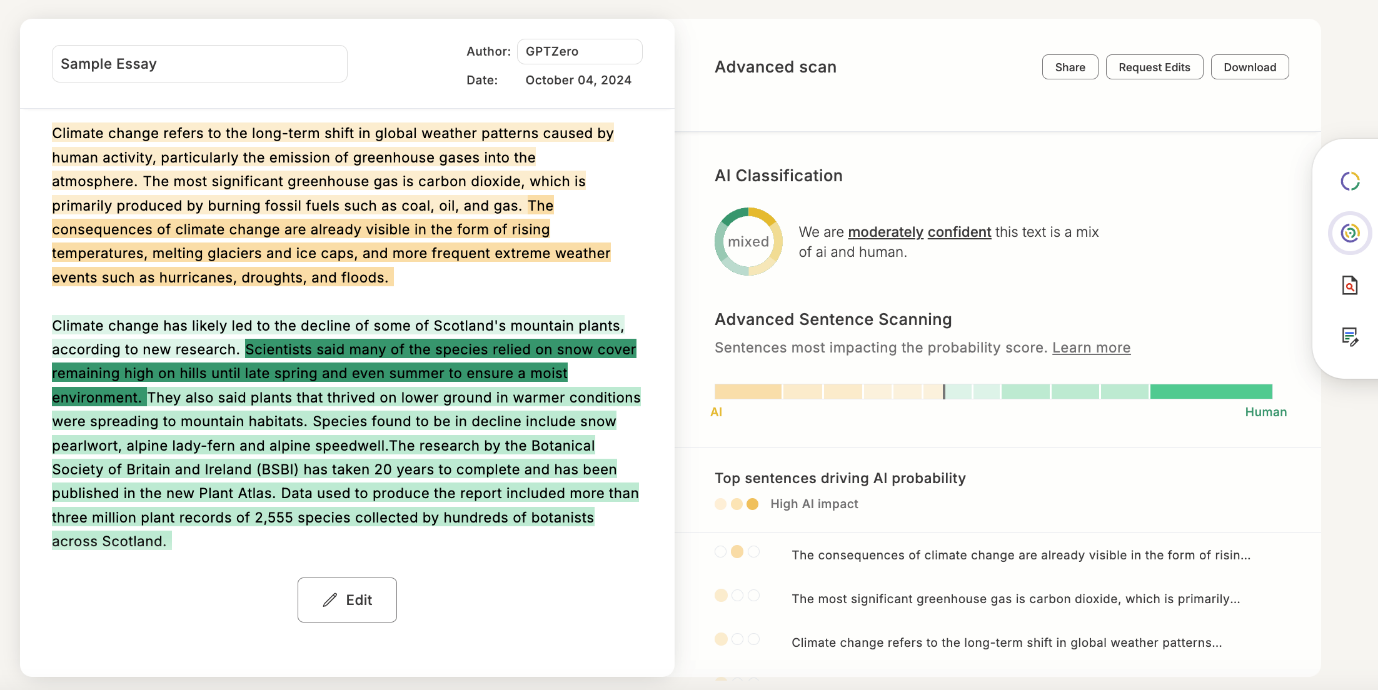

Exemple de classification avec mise en évidence au niveau des phrases par GPTZero, montrant comment le modèle évalue chaque ligne pour déterminer la probabilité de présence d'IA.

Perplexité

La perplexité est comparable à un indicateur de surprise dans le domaine des détecteurs de contenu généré par l'IA. Plus la perplexité est élevée, plus le détecteur est surpris par le texte qu'il analyse : les mots ou les structures de phrases inattendus ou inhabituels augmentent le score de perplexité. Si le texte est classé comme ayant une perplexité élevée, il est plus probable qu'il ait été créé par un humain. Si le texte est trop prévisible, il est probable qu'il ait été généré par l'IA.

Irrégularité

L'irrégularité est une mesure de la variation de la perplexité dans l'ensemble du texte – elle concerne davantage la fluidité du texte. Alors que l'écriture humaine présente un rythme de phrases courtes et longues, mêlant phrases simples et complexes, l'IA a tendance à être beaucoup plus prévisible. Cela signifie que ses phrases sont généralement assez uniformes.

Les générateurs d'IA ont donc tendance à produire des textes avec moins d’irrégularité et plus monotones, répétant certains mots ou certaines phrases trop fréquemment parce qu'ils les ont vus apparaître souvent dans leurs données d'entraînement.

L'interaction entre la perplexité et l'irrégularité

Alors que la perplexité concerne les surprises individuelles liées à des mots et expressions spécifiques, l'irrégularité s'intéresse davantage au rythme global d'un texte.

Un texte présentant une forte irrégularité peut entraîner une plus grande perplexité, car cela représente un défi pour l'IA. En effet, les changements soudains dans la longueur des phrases rendent plus difficile pour l'IA de prédire ce qui va suivre. Au contraire, une faible irrégularité signifie souvent une perplexité moins élevée : des phrases uniformes permettent à l'IA de repérer plus facilement le schéma et de prédire les mots suivants.

Les détecteurs de contenu généré par l'IA recherchent un équilibre entre perplexité et irrégularité qui imite la façon dont les humains écrivent et parlent naturellement. Une perplexité tout comme une irrégularité trop importante peuvent être un signal d'alarme.

Pourquoi les détecteurs d'IA sont-ils importants ?

À mesure que les outils d'IA deviennent plus conviviaux et que de plus en plus de personnes les utilisent, on assiste à une augmentation considérable du contenu généré par l'IA, ce qui soulève des questions sur l'intégrité et la qualité de ce contenu. En effet, selon les experts, jusqu'à 90 % du contenu en ligne pourrait être généré par l'IA dès 2026.

Les détecteurs de contenu généré par l'IA ont récemment gagné en popularité dans tous les secteurs pour plusieurs raisons liées au maintien des normes d'authenticité et de confiance :

Élèves

Une enquête Pew Research réalisée l'année dernière a révélé que 26 % des adolescents déclaraient utiliser ChatGPT pour leur travail scolaire, soit le double de l'année précédente. Les élèves étant de plus en plus soucieux d'être accusés d'utiliser l'IA dans leurs travaux, ils sont de plus en plus nombreux à utiliser des détecteurs d'IA pour démontrer de manière proactive l'originalité de leur travail avant de rendre leurs devoirs.

Établissements d'enseignement

Les collèges, lycées et établissements d'études supérieures utilisent des détecteurs d'IA pour préserver l'intégrité académique. Ils aident les enseignants à déterminer si les élèves ont eu recours de manière excessive à certains outils IA, afin de s'assurer que leur travail reflète fidèlement leur compréhension du sujet.

Dans cet épisode, intitulé « Enseignants vs étudiants : l'IA détruit-elle l'éducation ? », des étudiants et des enseignants lisent ensemble des passages à haute voix, tentent de deviner lesquels ont été rédigés par des humains et lesquels ont été générés par l'IA, puis vérifient leur intuition à l'aide de GPTZero.

Entreprises

Dans le milieu professionnel, les outils IA sont utilisés pour créer du contenu à grande échelle pour les sites web, les blogs et les réseaux sociaux, ainsi que pour les supports marketing et les communications internes. De nombreuses entreprises intègrent désormais la détection de l'IA dans leurs processus éditoriaux afin de se conformer aux exigences de transparence fixées par les Search Quality Rater Guidelines (directives d'évaluation de la qualité de recherche) 2025 de Google.

Recruteurs

Les recruteurs utilisent des détecteurs d'IA pour s'assurer que les documents de candidature, en particulier les lettres de motivation, ont bien été rédigés par les candidats. Cela permet d'assurer une évaluation équitable et d'éviter que des candidatures rédigées par l'IA ne passent entre les mailles du filet, ce qui ne ferait qu'alourdir inutilement la charge de travail.

Politique, journalisme et réseaux sociaux

Avec le développement des deepfakes et la propagation de fausses informations, les détecteurs d'IA sont utilisés pour évaluer l'intégrité des actualités et s'assurer que les faux contenus ne sont pas pris pour des informations authentiques. Ceci est particulièrement crucial pendant les périodes électorales, lorsque les contenus peuvent influencer l'opinion publique et menacer le processus démocratique.

Rédacteurs de contenu Web et rédacteurs publicitaires

Les rédacteurs qui utilisent des outils IA pour faciliter leur processus d'écriture soumettent souvent leur travail à des détecteurs IA avant publication. Cela leur permet d'éviter d'être signalés par les moteurs de recherche ou les algorithmes et garantit que leur contenu est reconnu comme étant original et rédigé par un humain.

Analystes judiciaires

Dans le domaine juridique et dans le cadre d'enquêtes, les analystes judiciaires utilisent des détecteurs d'IA pour vérifier l'origine des documents écrits. Ces outils peuvent aider à déterminer si des documents litigieux ont été créés par des humains ou par des systèmes d'IA, garantissant ainsi l'intégrité des pièces à conviction.

Formateurs et chercheurs en IA

Les développeurs et les chercheurs utilisent des détecteurs d'IA pour étudier le fonctionnement des systèmes de détection et former de manière plus responsable les futurs modèles d'IA. Comprendre ce qui rend un texte détectable leur permet de concevoir de nouveaux modèles qui favorisent la transparence et le développement éthique de l'IA.

Création d'un modèle d'IA personnalisé pour détecter l'IA

À mesure que l'IA évolue rapidement pour apprendre à paraître plus humaine, les détecteurs d'IA tels que GPTZero évoluent également pour s'adapter aux nouveaux modèles. Nous avons créé un modèle personnalisé qui s'entraîne sur des textes humains et générés par l’IA provenant des derniers modèles afin d'évaluer en permanence les différences clés entre ces derniers, au-delà de la simple perplexité et de l'irrégularité.

Aujourd'hui, notre modèle comprend également des fonctionnalités telles que notre scan avancé (un modèle de classification phrase par phrase), la recherche de texte sur Internet (qui vérifie si le texte a été trouvé dans des archives textuelles et Internet) et un bouclier (qui le protège contre les outils cherchant à exploiter les détecteurs d'IA). Nous combinons ces méthodes avec des moyens encore plus dynamiques pour suivre le rythme de l'IA et déjouer les nouvelles tentatives visant à contourner la détection de l'IA.

Nous collaborons également avec des établissements d'enseignement par l'intermédiaire de notre communauté de 1 300 enseignants ambassadeurs afin de perfectionner ces outils dans des conditions réelles.

Les membres de notre programme Enseignants ambassadeurs apprennent à aborder l'IA en salle de classe.

Quelle est la fiabilité des détecteurs d'IA ?

Aucun outil ne peut prétendre être exact à 100 %. L'objectif de tout outil de détection d’IA performant doit plutôt être d'atteindre le taux de fiabilité le plus élevé possible, avec le taux de faux positifs et de faux négatifs le plus bas possible. GPTZero affiche un taux de fiabilité de 99 % et un taux de faux positifs de 1 % lorsqu'il détecte des éléments générés par l'IA par rapport à des éléments rédigés par des humains.

Le véritable défi consiste à détecter les documents mixtes qui contiennent à la fois du contenu généré par l'IA et du contenu rédigé par des humains. GPTZero est bien plus performant que ses concurrents dans la détection de documents mixtes, avec un taux de précision de 96,5 %. Lorsque le contenu généré par l'IA a été modifié ou mélangé à des textes rédigés par l'homme, l'identification devient encore plus complexe. Les détecteurs peuvent également rencontrer des difficultés avec les styles d'écriture non conventionnels ou très créatifs qui ne correspondent pas aux données d'entraînement typiques et qui peuvent parfois entraîner une certaine incertitude.

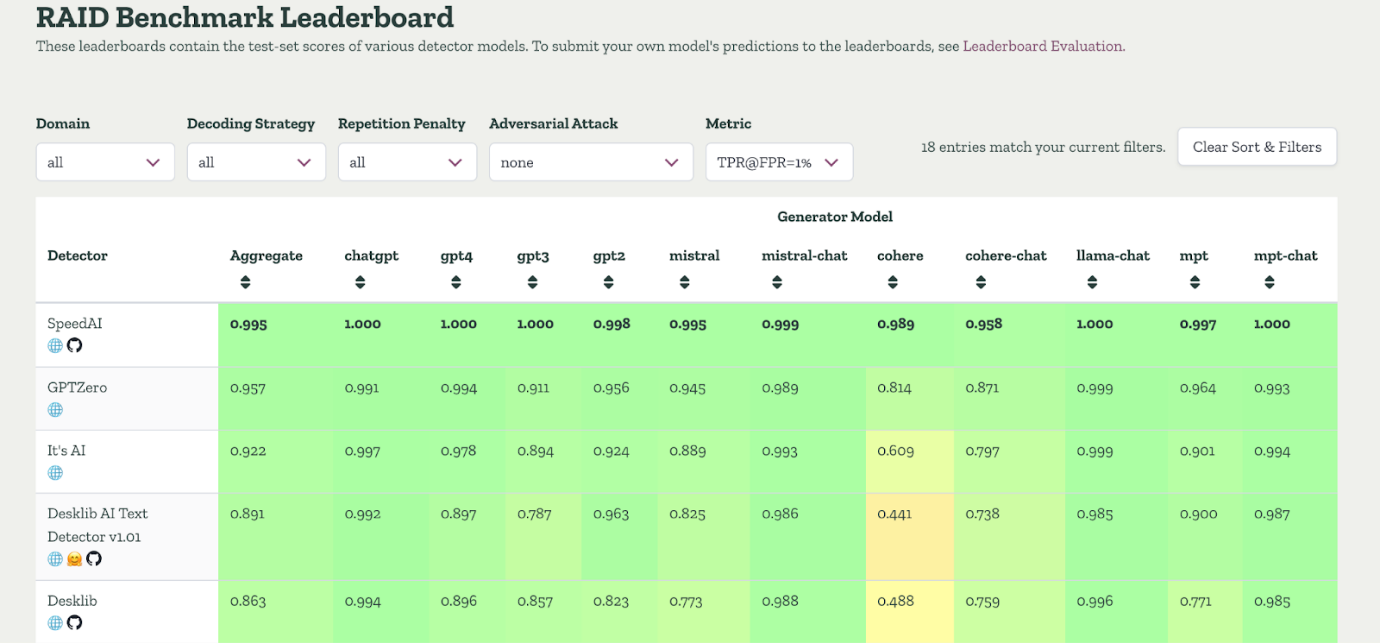

Cependant, GPTZero s'est une nouvelle fois imposé comme le détecteur le plus précis d'Amérique du Nord, selon les benchmarks indépendants de RAID, un ensemble complet de données comprenant 672 000 textes couvrant 11 domaines, 12 LLM et 12 attaques adverses. Sur RAID, GPTZero a correctement identifié 95,7 % des textes rédigés par l'IA, tout en ne classant incorrectement que 1 % des textes rédigés par des humains, avec une précision supérieure à 99 % sur les modèles modernes tels que GPT-4. Contrairement à ses concurrents tels que Copyleaks, Originality et Pangram, les performances de GPTZero sont restées constantes même dans des conditions adverses telles que la paraphrase ou le remplacement par des synonymes.

Résultats du benchmark RAID sans attaques adverses

Plusieurs facteurs viennent influencer la fiabilité des détecteurs d'IA. Les passages courts sont plus difficiles à analyser car ils offrent moins de schémas linguistiques à évaluer pour le modèle, tandis que les textes plus longs fournissent davantage de contexte et de cohérence pour la comparaison. À mesure que les systèmes IA évoluent, leur écriture devient de plus en plus humaine, ce qui rend plus difficile pour les détecteurs de repérer des différences marquées.

GPTZero est entraîné sur des millions de documents couvrant divers domaines d'écriture, notamment la création littéraire, la rédaction scientifique, les blogs, les articles d'actualité, etc. Nous testons nos modèles sur un ensemble inédit d'articles rédigés par des humains et par l'IA, issus d'une section de notre vaste base de données, en plus d'un ensemble plus restreint d'articles complexes qui ne font pas partie de son ensemble de données d'entraînement.

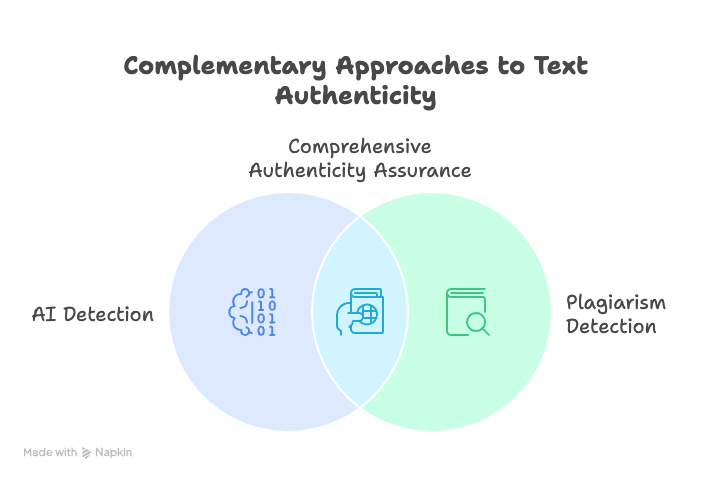

Détecteurs d'IA vs vérificateurs de plagiat

Les détecteurs d'IA examinent la manière dont le texte a été rédigé, tandis que les vérificateurs de plagiat recherchent l'origine du texte. Cette distinction est reconnue dans les lignes directrices 2024 de l'International Center for Academic Integrity (Centre international pour l'intégrité académique), qui recommande d'utiliser les deux outils conjointement.

Les détecteurs d'IA examinent la structure du texte, le choix des mots et le style général afin de déterminer s'il a été créé par une IA ou par un être humain. Ils font appel à des algorithmes avancés et à l'analyse linguistique.

Les vérificateurs de plagiat, quant à eux, sont plus simples et cherchent essentiellement à faire correspondre le texte et à le comparer à un vaste ensemble de données de textes existants. Lorsqu'ils détectent des similitudes ou des correspondances, ils les signalent comme un potentiel plagiat.

En substance, les détecteurs d'IA ont pour but de s'assurer que le contenu a bien été rédigé par un être humain, tandis que les vérificateurs de plagiat servent à confirmer qu'il n'a pas été copié à partir de sources existantes. Cependant, aucun de ces deux types d'outils n'est parfait et, dans les deux cas, les résultats doivent être évalués de manière critique et utilisés comme sources d'information plutôt qu'en tant que juges absolus.

Détecteurs d'images et de vidéos basés sur l'IA

Alors que les détecteurs basés sur le texte analysent les mots et les structures de phrases, les détecteurs d'images et de vidéos se concentrent sur l'identification des empreintes visuelles des modèles génératifs. Ces outils examinent des indices visuels subtils, tels que des irrégularités dans l'éclairage ou des anomalies dans les textures afin de vérifier l'authenticité.

Beaucoup utilisent également l'apprentissage profond pour comparer les caractéristiques visuelles à des ensembles de données connus d'images de synthèse et d’images authentiques. Par exemple, les détecteurs peuvent repérer des irrégularités dans les reflets, les textures de la peau ou les détails de l'arrière-plan qui révèlent souvent l'origine artificielle d'une image.

Les systèmes plus récents combinent l'analyse visuelle et l'analyse contextuelle, vérifiant non seulement ce qui apparaît dans une image ou un clip, mais aussi comment et où il a été partagé. Cette approche multimodale aide les plateformes et les chercheurs à évaluer l'authenticité de manière plus fiable, tous formats confondus.

Limites des détecteurs d'IA

Faux positifs ou faux négatifs

Les détecteurs d'IA fonctionnent sur la base de probabilités, et non de certitudes absolues, et peuvent parfois produire des faux positifs ou des faux négatifs. Cela s'explique par le fait que ces systèmes s'appuient sur des algorithmes qui analysent des modèles et évaluent la probabilité qu'un contenu donné ait été produit par une IA. Il arrive parfois que des contenus rédigés par des humains soient identifiés à tort comme ayant été générés par une IA. De même, des contenus générés par une IA peuvent être identifiés à tort comme ayant été rédigés par des humains. Chez GPTZero, nous expliquons plus en détail le fonctionnement de notre analyse comparative et la manière dont nous obtenons nos taux de fiabilité.

Formé en langue anglaise

La plupart des détecteurs d'IA sont formés sur des contenus en anglais et peuvent reconnaître les structures et les schémas courants de cette langue. Un détecteur d'IA peut être moins efficace (voire inefficace) lorsqu'il analyse des contenus multilingues ou des textes dans d'autres langues. Pour les contenus non anglophones, un détecteur d'IA peut ne pas être capable de reconnaître les caractéristiques spécifiques sur lesquelles il a été formé, car elles diffèrent trop de ce qu'il a appris à reconnaître, ce qui le rend moins fiable.

Chez GPTZero, nous avons réalisé d'importants progrès pour pallier les limites liées à la langue en utilisant un ensemble de données d'évaluation plus rigoureux. En affinant l'entraînement des modèles et en intégrant des techniques de suppression des biais, nous avons amélioré la fiabilité de GPTZero sur différents contextes de langue.

Des outils d'aide à la rédaction recourant de plus en plus à l'IA

De nombreux détecteurs d'IA ne sont généralement pas en mesure de faire la différence entre une assistance IA utilisée de manière éthique (avec des outils grammaticaux tels que Grammarly) et un contenu entièrement généré par l'IA. Certains systèmes ne peuvent pas toujours faire la différence entre une personne qui utilise l'IA pour des modifications mineures, telles que des corrections grammaticales, et une qui s'appuie sur l'IA pour générer l'intégralité du texte.

GPTZero a formé ses modèles pour tenir compte de cela, et le « bouclier anti-paraphrase » de GPTZero fait la distinction entre les outils d'édition légère (tels que Grammarly) et une réécriture complète par l'IA.

Difficulté à détecter les modèles d'IA avancés

À mesure que les systèmes d'IA deviennent plus sophistiqués, les textes qu’ils génèrent deviennent presque impossibles à distinguer de ceux rédigés par des humains. Les nouveaux modèles sont entraînés à partir d'ensembles de données considérables et variés, et peuvent imiter le rythme naturel, le ton et même les nuances émotionnelles avec une précision remarquable. Il devient donc de plus en plus difficile aux méthodes de détection traditionnelles de suivre le rythme, car les indices linguistiques habituels qui permettaient autrefois de repérer l'IA, tels que les phrases répétitives ou la grammaire trop parfaite, sont désormais souvent beaucoup moins évidents.

Il n'existe pas de preuve irréfutable.

Les détecteurs d'IA fonctionnent sur la base de probabilités. Ainsi, un score élevé de probabilité d'IA signifie que le texte présente des caractéristiques communes à l'écriture générée par l'IA. Ceci est très différent de pouvoir affirmer qu'un texte a été sans aucun doute produit par une IA. En ce sens, les détecteurs d'IA ne peuvent pas fournir une certitude absolue. C'est pourquoi, dans la pratique, ces outils sont plus efficaces lorsqu'ils sont utilisés dans le cadre d'un processus de vérification plus large, en complément du jugement humain et d'autres méthodes de vérification.

Pourquoi une dépendance excessive est risquée

Utilisés seuls, les détecteurs d'IA peuvent conduire à des résultats injustes, tels que le signalement erroné d'écrits d'étudiants ou des erreurs dans la modération de contenu. L'approche la plus responsable consiste à les combiner avec d'autres méthodes de vérification, telles que les contrôles de plagiat et l'analyse de l'historique d'écriture (comme le rapport d'écriture de GPTZero).

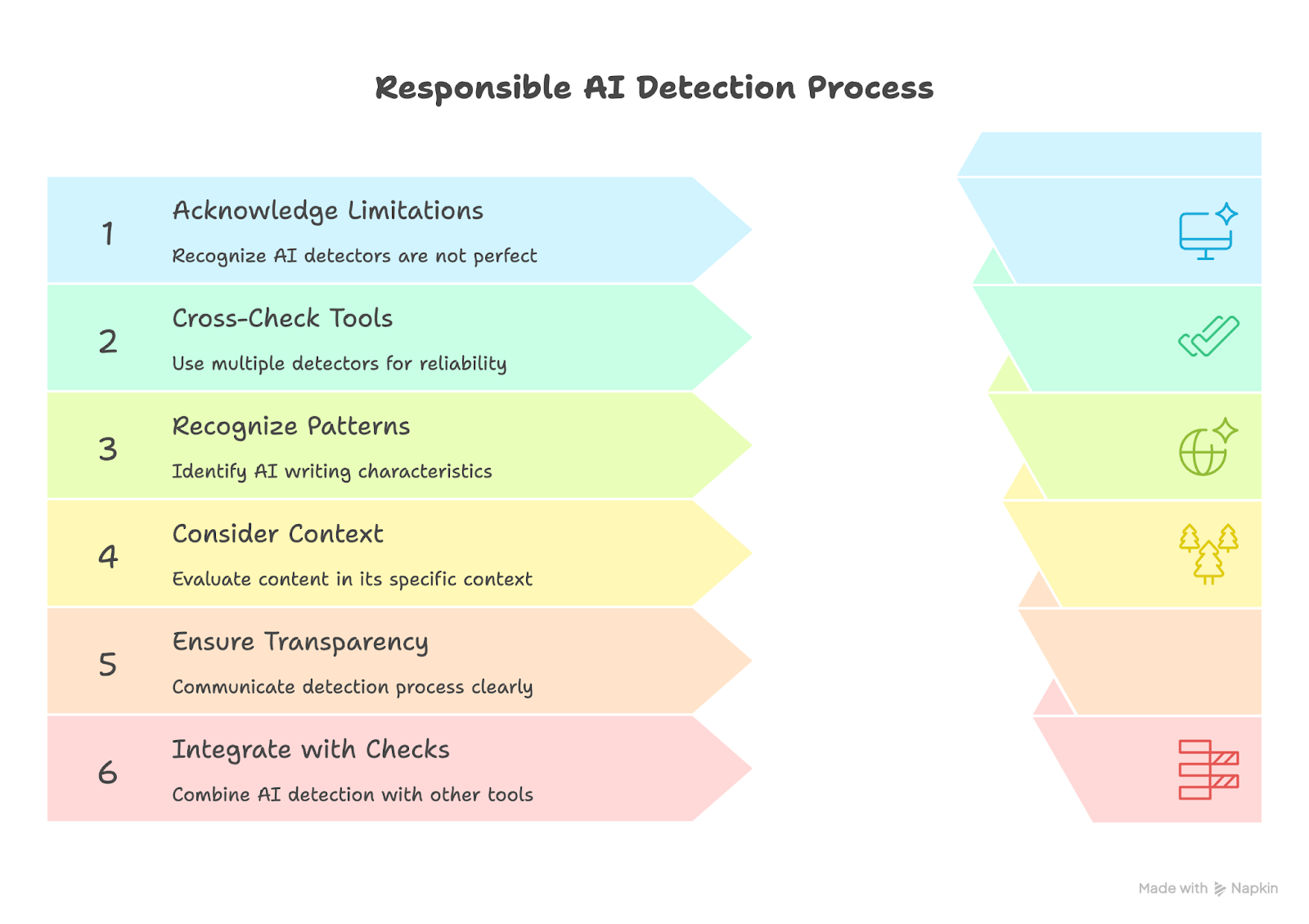

Bonnes pratiques pour l'utilisation des détecteurs d'IA

Compte tenu de tout ce qui précède, les détecteurs de contenu IA doivent être considérés comme des outils s'inscrivant dans une stratégie plus large visant à évaluer l'intégrité du contenu, et non comme des juges uniques de la qualité du contenu. Pour utiliser efficacement les détecteurs d'IA, nous devons reconnaître leurs limites et faire appel au jugement humain pour le contexte spécifique dans lequel le contenu est créé.

Vous trouverez ci-dessous les mesures que vous pouvez prendre (si vous travaillez dans le domaine de l'éducation, nous vous recommandons également de consulter notre article intitulé « Comment les enseignants doivent-ils aborder l'IA et l'intégrité académique ? »).

Reconnaître les limites

Aucun détecteur d'IA au monde n'est infaillible. Ces outils peuvent parfois classer un texte de manière erronée, donnant lieu à des faux positifs ou à des faux négatifs. Leurs conclusions doivent être considérées comme une piste à explorer, un signal invitant à approfondir l'enquête, et non comme un verdict définitif.

Recoupez les résultats avec plusieurs outils

Se fier à un seul détecteur peut créer des angles morts et entraîner une dépendance excessive à cet outil. Il est recommandé d'utiliser plusieurs outils de détection d'IA, afin d'obtenir une image plus large et plus fiable et de minimiser le risque d'erreur.

Apprenez à reconnaître les schémas d'écriture de l'IA

Les textes générés par l'IA suivent souvent des rythmes prévisibles et répètent certains mots ou expressions. Ils sont également dépourvus de nuances. Comprendre ces tendances facilite l'interprétation des résultats du détecteur et permet d'identifier plus facilement les textes qui semblent avoir été rédigés par une machine.

Tenez compte du contexte et de l'intention

Un résultat signalé doit toujours être examiné de plus près. Comparez le texte aux tournures, au ton et à la clarté habituels de la personne. Si le style semble sensiblement différent, la détection de l'IA peut être un point de départ utile pour l'examen, mais elle ne doit jamais être le seul facteur déterminant dans une décision.

Faites preuve de transparence en matière de détection

Que ce soit dans le milieu universitaire ou professionnel, il est de plus en plus important d'expliquer comment la détection par IA s'intègre dans votre processus d'évaluation. La définition de normes claires concernant le moment et la manière dont les résultats sont utilisés contribue à instaurer la confiance et à éviter une dépendance excessive à l'automatisation. (Si vous avez besoin d'aide pour définir une politique pour votre établissement, ce guide pourrait vous être utile.)

Utilisez la détection par IA dans le cadre d'un contrôle plus large de l'originalité

La détection par IA fonctionne mieux lorsqu'elle est associée à d'autres outils de vérification tels que les vérificateurs de plagiat et la validation des citations. Ensemble, ces outils offrent une image plus complète de la manière dont une personne a réalisé son travail et, dans l'ensemble, ils permettent une approche plus holistique de l'évaluation du contenu.

En conclusion, ces outils ne constituent pas des références absolues. Ils doivent venir compléter le jugement humain, en particulier dans les situations où les faux positifs et les faux négatifs peuvent entraîner des conséquences importantes. La meilleure façon d'utiliser les détecteurs d'IA de manière responsable est d'adopter une approche équilibrée qui privilégie l'équité plutôt que la facilité.

L'avenir de la technologie de détection de l'IA

À mesure que l'IA générative progresse, les outils conçus pour la détecter évoluent également. La prochaine génération de détecteurs ira au-delà du texte et sera également capable d'analyser les contenus multimédias afin de repérer les éléments créés ou modifiés par l'IA. Les chercheurs travaillent déjà sur des systèmes capables de s'adapter en temps réel à l'apparition de nouveaux modèles, plutôt que de s'appuyer sur d'anciennes références qui deviennent rapidement obsolètes.

Nous observons déjà des recherches prometteuses autour de modèles de détection dynamiques capables de s'adapter en temps réel aux nouveaux systèmes d'IA, plutôt que de s'appuyer sur des référentiels statiques. Dans un avenir proche, les outils les plus efficaces contribueront à la mise en place de systèmes où la transparence et la paternité sont intégrées dès le départ et la conception.

Conclusion

Les détecteurs de contenu IA sont plus essentiels que jamais, car ils aident les enseignants à maintenir l'honnêteté académique et les entreprises à préserver la confiance, à une époque où l'automatisation est de plus en plus répandue. Comme tous les outils, ils sont plus efficaces lorsqu'ils sont utilisés de manière réfléchie, dans le cadre d'un engagement plus large en faveur de la transparence.

À notre avis, les meilleurs détecteurs IA sont conçus pour protéger l'authenticité et soutenir un environnement numérique où l'originalité compte encore, ou, en d'autres termes, pour préserver ce qui est humain.